在安卓手机上使用Ollama运行本地大模型

众所周知,我们国产模型DeepSeek大过年的给美股来了几下子,在我们过年的时候让洋人过不了一个安稳年(滑稽)。直到我写这篇帖子的时候,DeepSeek 的部分服务仍然处于一个不可用的状态。

本着增强动手能力(整活)的心态,我决定在我的手机上安装一个deepseek-r1模型。由于在电脑上安装过于简单,将不再赘述。

需要的东西

- 一部手机

- Termux

演示条件

- 手机:REDMI K80 Pro

(王腾有大帝之姿) - Termux: ZeroTermux[1] 0.118.1.41

正文

注意

本文开始前,假设你熟练掌握 Linux 的使用方法,并可以正常访问国际互联网。

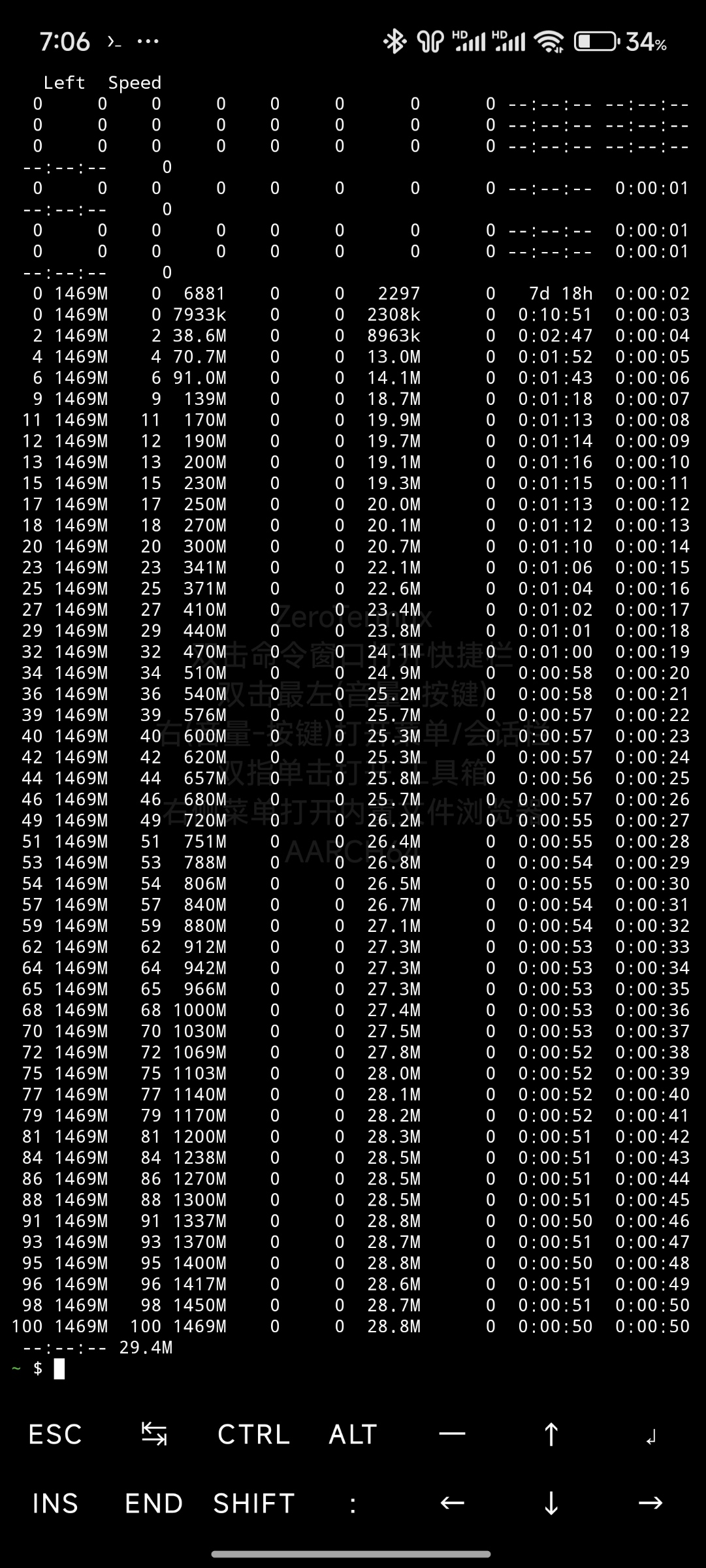

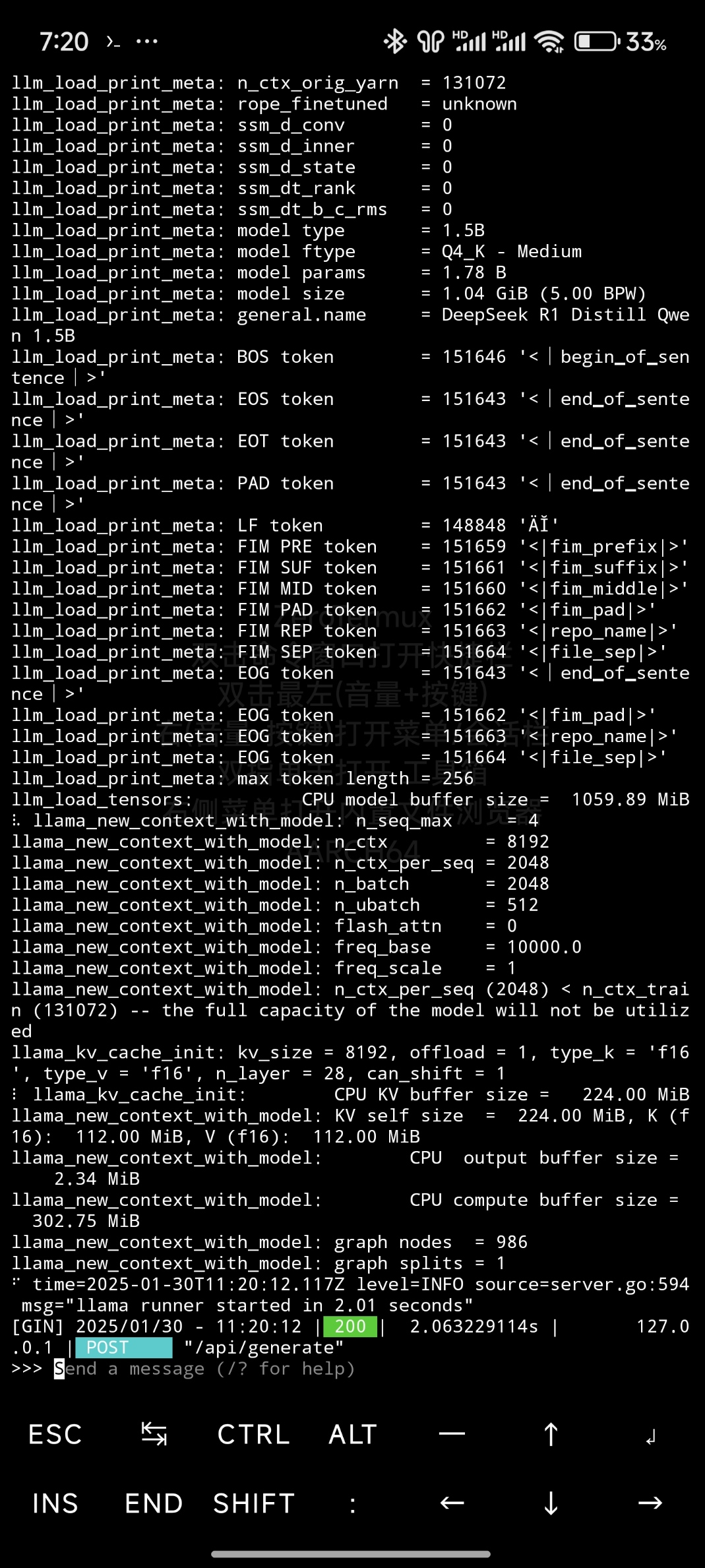

由于手机的性能就摆在那里,所以只能使用1.5b的模型。在开始前,假设你已经安装 Termux。

手机无 Root 环境。(有 Root 更好)

经过测试,在这里应该使用 Proot 容器,无法直接在 Termux 中运行,我这里使用的是Kali容器[2],你也可以使用其他容器,如ubuntu.

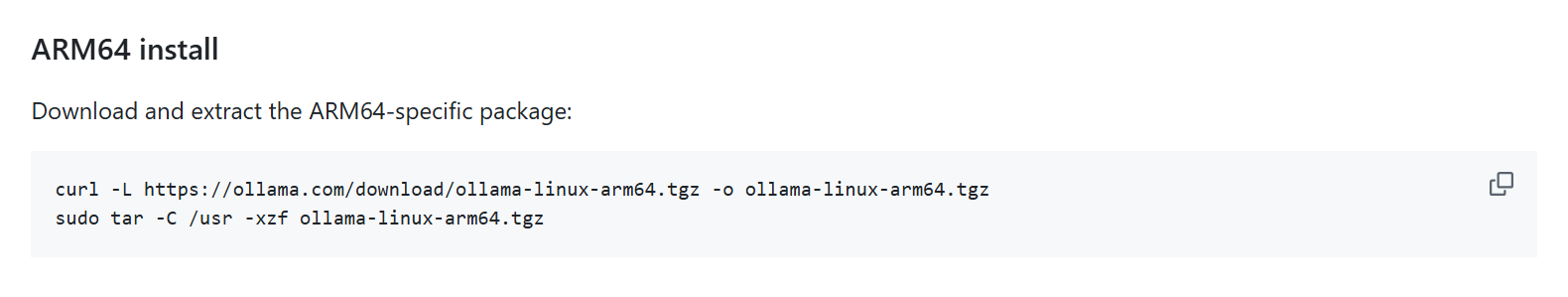

使用手机打开Ollama Linux Manual install的ARM64 install(毕竟手机是 arm64 架构),并复制第一行命令到终端(不要带上第二行)。

在运行之后将会下载 Ollama 的安装包,在下载完之后,复制第二行命令,并删去开头的sudo(由于 Termux 特性),然后运行。

如果你懒的话,可以复制我整理好的命令。

curl -L https://ollama.com/download/ollama-linux-arm64.tgz -o ollama-linux-arm64.tgz && tar -C /usr -xzf ollama-linux-arm64.tgz

由于没有 root 环境,无法使用"Adding Ollama as a startup service (recommended)"步骤,我们要手动启动一下 ollama 服务。

ollama serve &

Linux 在执行命令时,可以使用

&符号来使该命令在后台运行,而不阻塞终端的使用。当了解这一点之后我们就可以编写命令。

然后就可以根据自己的需要运行模型。就比如说,我要运行一个deepseek-r1:1.5b的模型,就可以这样写:

ollama run deepseek-r1:1.5b

其他内容详见Ollama.

ZeroTermux 是 Termux 的修改版本。 ↩︎